library(tidyverse)1 Was ist die Regression?

In diesem Post geht es um die einfache Regression (d.h. mit einem Prädiktor); genauer gesagt um die Frage, wie man auf die Formeln der Koeffizienten der einfachen Regression kommt.

Gehen wir von einigen zweidimensionalen Datenpunkten aus, die zu einem Phänomen gemessen wurden: .

Gehen wir weiter davon aus, dass der Zusammenhang in Wirklichkeit von einer Geraden erklärt werden kann:

Eine Gerade kann durch zwei Koeffizienten definiert werden, den Achsenabschnitt und die Steigung .

Für jeden Datenpunkt können wir die Abweichung (den Fehler) zum vorhergesagten Wert ausrechnen:

Nennen wir die Summe der quadrierten Fehler im Folgenden (für Quadratsumme):

Alle Summen belaufen sich über die Beobachtungen .

Betrachten wir das an einem Datenbeispiel:

d <- mtcars

lm1 <- lm(mpg ~ hp, data = d)

d <-

d %>%

mutate(pred = predict(lm1),

resid = residuals(lm1))Jetzt visualisieren wir die Residuen (Abweichungen, Fehler):

ggplot(d,

aes(x = hp, y = mpg)) +

geom_smooth(method = "lm", se = FALSE, color = "dodgerblue") +

geom_segment(aes(xend = hp, yend = pred), alpha = .5) +

geom_point() +

geom_hline(yintercept = mean(d$mpg),

color = "grey60", linetype = "dashed") +

geom_vline(xintercept = mean(d$hp),

color = "grey60", linetype = "dashed") +

annotate("point", x = mean(d$hp), y = mean(d$mpg),

size = 5, color = "red", alpha = .5)

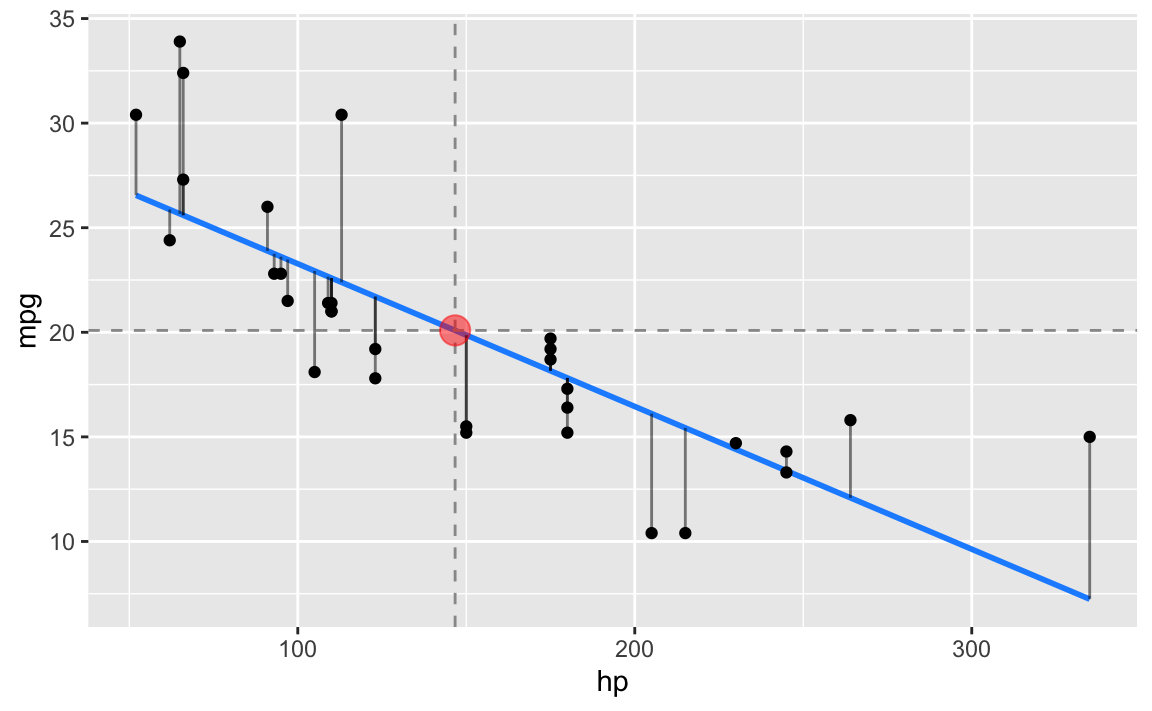

Die blaue Gerade ist die Regressionsgerade; die vertikalen Balken stellen die Residuen dar und die gestrichelten Linien repräsentieren jeweils die Mittelwerte von hp bzw. mpg. Man beachte, dass der Schnittpunkt der Mittelwertslinien auf der Regressionsgeraden liegt.

2 Wie findet man die Regressionsgerade?

Um die Koeffizienten der Regressionsgeraden zu bestimmen, können wir die Methode der kleinsten Quadrate (least squares bzw. ordinary least squares) verwenden. Diese Methode gibt uns diejenigen Koeffizienten der Regressionsgeraden (also und ), die die Quadratsumme (QS) der Residuen minimieren.

Um die Quadratsumme zu minimieren, bilden wir jeweils die erste (parzielle) Ableitung und setzen diese Null. Anschließend löst man nach dem gesuchten Koeffizienten auf. Beginnen wir mit .

2.1

Wir leiten nach ab (Kettenregel) und setzen die Gleichung Null:

Teilen durch -2:

Auflösen nach , der gesuchten Größe:

:

Teilen durch :

Kürzer fassen:

Das Ergebnis zeigt auch, dass der Punkt auf der Regressionsgerade liegt.

2.2

Analog verfahren wir für den zweiten Koeffizienten, . Wieder bilden wir die parzielle Ableitung, setzen diese Null und lösen nach dem gesuchten Koeffizienten auf. Das Nachdifferenzieren (Kettenregel) liefert allerdings ein anderes Ergebnis:

Gleichung multiplizieren mit und letzten Faktor, nach vorne ziehen:

Summenzeichen auflösen:

Jetzt setzen wir in ein:

Klammer auflösen:

Alle Terme mit auf die rechte Seite bringen:

vor die Klammer ziehen:

Nach auflösen:

Wie man sieht, kann als das Verhältnis von Kovarianz zu Varianz dargestellt werden.

2.3 Weitere Umformung von

3 Quellenangabe

Dies Post ist eine kommentierte und leicht angepasste Version von diesem Post auf StackExchange.

4 Fazit

In diesem Post ging es um die Ableitung der Formeln der Regressionskoeffizienten, zumindest der einfachen Regression. Dabei wurden grundlegende Algebra und partielle Ableitungen verwendet. Wir haben also bewiesen, dass die Regressionskoeffizienten die Form haben, wie sie gewöhnlich in einführenden, angewandten Lehrbüchern gezeigt werden.

Für die Ableitung der multiplen Regression sind Ansätze auf Basis der linearen Algebra praktischer.